云服務器搭建Redis集群主從數據不同步的陷阱與數據處理服務的應對策略

在當今數據驅動的業務環境中,許多企業和開發者選擇在云服務器上搭建Redis集群來提升數據處理性能和可靠性。盡管Redis主從復制機制在理論上是成熟的,但在實際部署中,主從數據不同步的問題卻頻頻發生,給數據處理服務帶來嚴重挑戰。本文將深入分析這一問題出現的根本原因,并提出切實可行的解決方案。

網絡延遲和帶寬限制是主從數據不同步的常見元兇。在云環境中,主節點和從節點可能分布在不同的可用區或地域,網絡傳輸的延遲可能導致從節點無法及時接收主節點的數據同步。如果網絡帶寬不足,尤其是在數據寫入頻繁的場景下,從節點可能無法跟上主節點的更新速度,從而產生數據滯后甚至丟失。

配置錯誤也不容忽視。例如,Redis的復制緩沖區(replication buffer)大小設置不當,或主從節點的超時時間配置不匹配,都可能導致復制中斷。另外,如果從節點在重啟后未正確連接到主節點,或者主節點變更后從節點未及時更新配置,也會引發數據不一致。

資源競爭和性能瓶頸也是一個關鍵因素。當主節點負載過高,CPU或內存資源不足時,復制進程可能被阻塞,導致從節點數據更新延遲。在云服務器上,如果實例規格選擇不當(如內存不足或I/O性能差),這個問題會進一步加劇。

對于數據處理服務而言,主從數據不同步可能導致嚴重后果:例如,在讀取分離架構中,應用從從節點讀取到過時數據,引發業務邏輯錯誤;在備份和恢復過程中,數據不一致可能使得災難恢復失效。因此,必須采取多層次的應對措施。

一方面,優化網絡架構是關鍵。建議將主從節點部署在同一可用區內以減少延遲,并使用云服務商提供的高帶寬網絡。監控網絡流量和延遲,設置警報機制以便及時發現問題。

另一方面,合理配置Redis參數至關重要。確保復制緩沖區大小足夠容納高峰期數據,調整repl-timeout和repl-ping-slave-period等參數以適應云環境。啟用Redis的持久化機制(如AOF和RDB),并結合哨兵(Sentinel)或集群模式來自動處理故障切換,可以減少人為干預錯誤。

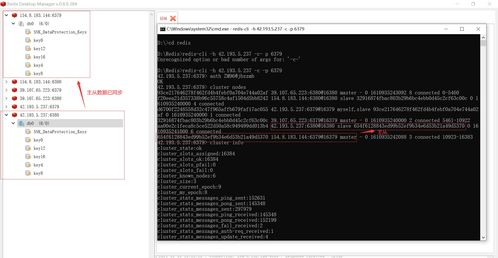

在數據處理服務層面,實現數據一致性校驗和自動修復機制是必要的。例如,定期對比主從節點的數據快照,使用工具如redis-cli --cluster check進行健康檢查。對于關鍵業務,可以考慮引入最終一致性策略,或在應用層添加重試和補償邏輯。

借助云平臺提供的監控和日志服務(如AWS CloudWatch或阿里云監控),實時跟蹤Redis集群的性能指標,如復制延遲、內存使用率和連接數,能夠幫助提前識別潛在問題。

在云服務器上搭建Redis集群時,主從數據不同步是一個需要高度警惕的陷阱。通過綜合優化網絡、配置、資源管理和數據處理流程,我們可以有效規避風險,確保數據處理服務的穩定性和可靠性。只有防患于未然,才能在數據洪流中游刃有余。

如若轉載,請注明出處:http://www.dzs1.cn/product/10.html

更新時間:2026-01-09 20:59:54